به گزارش سراج24؛ هوش مصنوعی (AI) به یکی از مهمترین ابزارهای عصر حاضر تبدیل شده است، که تأثیرات آن از دنیای فناوری فراتر رفته و وارد تمامی جنبههای زندگی روزمره شده است؛ از حملونقل و بهداشت گرفته تا امنیت ملی و روابط بینالملل. با این حال، چالشهای اخلاقی و مدیریتی این فناوری همچنان ذهن مردم و سیاستگذاران را به خود مشغول کرده است.

مطالعهای از سوی مرکز «حاکمیت هوش مصنوعی» در دانشگاه آکسفورد تلاش کرده است تا نگرشهای مردم آمریکا نسبت به این فناوری، چالشهای حاکمیتی و اعتماد به نهادهای مختلف در مدیریت AI را بررسی کند. این مطالعه که دادههای حاصل از نظرسنجی بیش از 2000 آمریکایی را تحلیل کرده، تصویری شفاف از امیدها و نگرانیهای مردم نسبت به این فناوری ارائه میدهد.

نگرش عمومی به توسعه هوش مصنوعی

♦️حمایت مشروط: 41 درصد از شرکتکنندگان در نظرسنجی اعلام کردند که از توسعه هوش مصنوعی حمایت میکنند. اما این حمایت بیقیدوشرط نیست؛ 82 درصد از مردم معتقدند که AI باید تحت نظارت و مدیریت دقیق باشد. در حالی که تنها 22 درصد از مردم با توسعه این فناوری مخالف هستند، 28 درصد از پاسخدهندگان موضعی خنثی گرفتهاند و نشان دادهاند که هنوز اطلاعات یا درک کافی از این فناوری ندارند.

♦️عوامل جمعیتی: ویژگیهای جمعیتی نقش مهمی در نگرشها نسبت به هوش مصنوعی ایفا میکنند. حمایت از AI در میان مردان (47 درصد) بیشتر از زنان (35 درصد) است. افراد با درآمد بالاتر (59 درصد از کسانی که بیش از 100,000 دلار در سال درآمد دارند) و کسانی که دارای مدرک دانشگاهی هستند (57 درصد)، نسبت به سایر گروهها حمایت بیشتری نشان دادهاند. از سوی دیگر، افراد با درآمد کمتر و تحصیلات پایینتر نگرانی بیشتری درباره تأثیرات منفی این فناوری، بهویژه در حوزه اشتغال، دارند.

چالشهای اخلاقی و حاکمیتی هوش مصنوعی

مطالعه مرکز «حاکمیت هوش مصنوعی» نشان میدهد که مردم آمریکا آگاهانه نگرانیهایی درباره تأثیرات بالقوه منفی AI و نیاز به مدیریت این فناوری دارند. این نگرانیها در حوزههای مختلفی از جمله حفظ حریم خصوصی، امنیت، و نظارت دیجیتال دیده میشود.

مسائل کلیدی

بررسی 13 چالش اصلی مرتبط با حاکمیت هوش مصنوعی نشان میدهد که مردم آمریکا روی موارد خاصی تمرکز دارند:

♦️حفاظت از حریم خصوصی دادهها

پیشرفتهای سریع هوش مصنوعی باعث افزایش حجم دادههای شخصی شده است که برای یادگیری و تصمیمگیری توسط سیستمها استفاده میشود. حدود 70 درصد از پاسخدهندگان، حفاظت از حریم خصوصی را بهعنوان یکی از مهمترین موضوعات شناسایی کردهاند. این نگرانی زمانی جدیتر میشود که AI در حوزههایی نظیر تبلیغات هدفمند یا تحلیل دادههای پزشکی استفاده شود.

♦️حملات سایبری تقویتشده با هوش مصنوعی

استفاده از AI در حوزه سایبری نگرانیهای جدیدی ایجاد کرده است. حدود 65 درصد از شرکتکنندگان معتقدند که خطر حملات سایبری تقویتشده با هوش مصنوعی یکی از چالشهای مهم است. این فناوری میتواند به توسعه حملاتی پیچیدهتر منجر شود که مقابله با آنها دشوارتر است. به عنوان مثال، الگوریتمهای AI قادر به تولید ایمیلهای فیشینگ بسیار باورپذیر یا کشف نقاط ضعف در سیستمهای امنیتی هستند.

♦️نظارت و دستکاری دیجیتال

62 درصد از مردم آمریکا استفاده از AI در ابزارهای نظارتی را چالشی جدی میدانند. این فناوری میتواند برای نظارتهای گستردهتر و حتی دستکاری رفتار اجتماعی و سیاسی استفاده شود. به عنوان نمونه، هوش مصنوعی میتواند در طراحی تبلیغات سیاسی یا انتشار اطلاعات جعلی در رسانههای اجتماعی نقش داشته باشد.

تفاوت میان گروههای اجتماعی

پاسخها نشان میدهند که نگرانی نسبت به چالشهای هوش مصنوعی میان گروههای جمعیتی مختلف متفاوت است.

♦️سن و تجربه

افراد بالای 73 سال، به دلیل تجربه بیشتر با تغییرات فناورانه، اهمیت بیشتری به مدیریت AI میدهند. در مقابل، جوانان زیر 38 سال که معمولاً کاربران فعالتر فناوری هستند، این چالشها را کمتر مهم میدانند. این تفاوت نگرشی ممکن است ناشی از سطح اعتماد بیشتر جوانان به فناوری باشد.

♦️تحصیلات و تخصص فنی

افرادی که دارای مدرک مهندسی یا علوم کامپیوتر هستند، نسبت به کسانی که تجربهای در این حوزه ندارند، چالشهای حاکمیتی را کمتر مهم تلقی میکنند. این گروه از افراد احتمالاً به دلیل درک فنی بهتر از قابلیتهای هوش مصنوعی، نگرانی کمتری درباره سوءاستفاده از آن دارند.

امنیت جهانی و رقابت چین و آمریکا

یکی دیگر از موضوعات کلیدی که در این مطالعه برجسته شده است، نگرانی درباره رقابت هوش مصنوعی میان دو قدرت جهانی، آمریکا و چین، است.

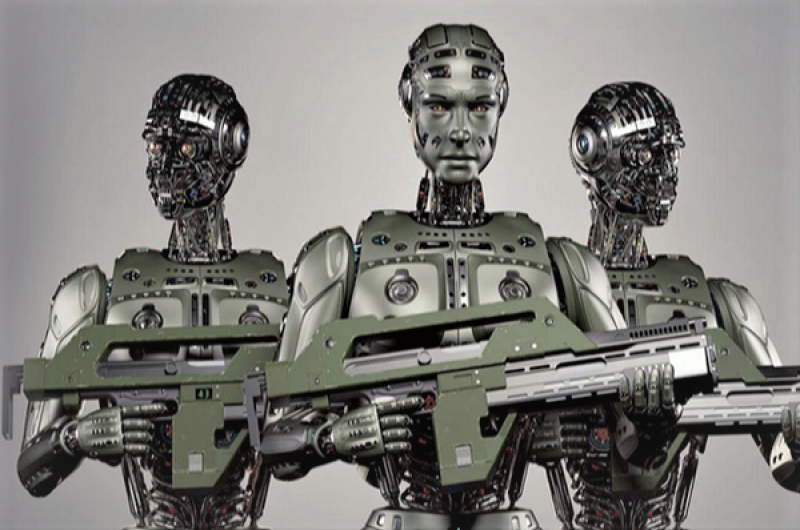

♦️رقابت تسلیحاتی AI

58 درصد از پاسخدهندگان اعلام کردند که جلوگیری از رقابت تسلیحاتی هوش مصنوعی میان این دو کشور بسیار مهم است. آنها باور دارند که این رقابت میتواند به تسلیحات خودمختاری منجر شود که کنترل آنها در مواقع بحرانی دشوار خواهد بود.

♦️نیاز به همکاری بینالمللی

با وجود رقابت، 45 درصد از شرکتکنندگان معتقدند که همکاری میان آمریکا و چین میتواند به کاهش خطرات جهانی AI کمک کند. به عنوان مثال، تنظیم پروتکلهای اخلاقی مشترک یا اشتراکگذاری دادههای تحقیقاتی میتواند نقش مهمی در کاهش تنشها داشته باشد.

♦️درک عمومی از رقابت

بسیاری از مردم آمریکا از پیشرفتهای چین در حوزه AI آگاه نیستند. تنها 32 درصد از پاسخدهندگان پیشبینی کردهاند که چین میتواند در آینده نزدیک از آمریکا پیشی بگیرد، در حالی که گزارشهای جهانی نشان میدهند که چین در حال حاضر سرمایهگذاریهای گستردهای در این حوزه انجام داده است.

مسائل بلندمدت: هوش مصنوعی و انقراض بشر

چالشهای هوش مصنوعی تنها به خطرات کوتاهمدت محدود نمیشود؛ بلکه مسائل بلندمدت نظیر ظهور هوش مصنوعی سطح بالا (AGI) نیز در این گزارش بررسی شدهاند.

54 درصد از پاسخدهندگان پیشبینی کردهاند که AGI تا سال 2028 به واقعیت میپیوندد. با این حال، 12 درصد معتقدند که این فناوری میتواند به انقراض بشر منجر شود. این نگرانیها ناشی از سناریوهایی است که در آن هوش مصنوعی تصمیمات خودمختار و غیرقابلکنترل میگیرد.

♦️تأثیر بر بازار کار

نگرانی درباره جایگزینی شغلها با اتوماسیون نیز یک مسئله مهم است. طبق نظرسنجی، 19 درصد از افرادی که کمتر از 50,000 دلار درآمد دارند، معتقدند که شغل خود را در آینده به دلیل اتوماسیون از دست خواهند داد، در حالی که این نگرانی در میان افراد با درآمد بالاتر کمتر است.

اعتماد به نهادها برای مدیریت هوش مصنوعی

♦️پژوهشگران دانشگاهی و ارتش در صدر

بر اساس دادههای نظرسنجی، پژوهشگران دانشگاهی و ارتش ایالات متحده بالاترین سطح اعتماد عمومی را در میان تمامی نهادها کسب کردهاند. حدود 50 درصد از پاسخدهندگان به پژوهشگران دانشگاهی و 49 درصد به ارتش آمریکا اعتماد دارند. این نتایج نشاندهنده باور عمومی است که نهادهای علمی و امنیتی میتوانند به بهترین شکل فناوریهای جدید را برای منافع عمومی مدیریت کنند.

اعتماد به ارتش احتمالاً به دلیل سوابق آن در مدیریت فناوریهای حساس و همچنین نقش کلیدی آن در امنیت ملی است. در مقابل، اعتماد به پژوهشگران دانشگاهی ممکن است ناشی از این باشد که آنها به طور سنتی بهعنوان بازیگرانی بیطرف و متمرکز بر دانش عمومی شناخته میشوند.

♦️اعتماد پایین به شرکتهای فناوری

شرکتهای فناوری نیز مورد ارزیابی قرار گرفتهاند، اما نتایج نشاندهنده سطح پایین اعتماد عمومی به آنهاست. در حالی که 44 درصد از پاسخدهندگان به طور کلی به شرکتهای فناوری اعتماد دارند، فیسبوک به عنوان یکی از کماعتمادترین شرکتها شناخته شده است. 41 درصد از مردم اعلام کردهاند که هیچ اعتمادی به این شرکت ندارند.

این بیاعتمادی ممکن است ناشی از رسواییهایی همچون ماجرای «کمبریج آنالیتیکا» باشد که در آن اطلاعات شخصی میلیونها کاربر بدون رضایت آنها برای اهداف سیاسی مورد استفاده قرار گرفت. این مسئله، همراه با نگرانیهای عمومی درباره شفافیت و اخلاق در مدیریت دادهها، تأثیر منفی بر اعتبار این شرکت داشته است.

♦️سازمانهای غیرانتفاعی: گزینهای جایگزین

سازمانهای غیرانتفاعی مانند OpenAI و CERN از اعتماد بیشتری نسبت به دولتها برخوردارند. مردم این سازمانها را کمتر تحت تأثیر منافع اقتصادی یا سیاسی میدانند. این سازمانها با تأکید بر شفافیت، اخلاق، و رویکرد بیطرفانه در توسعه هوش مصنوعی، توانستهاند اعتماد عمومی را جلب کنند. با این حال، آگاهی عمومی از این نهادها همچنان محدود است، چرا که حدود یکپنجم از پاسخدهندگان در نظرسنجی اعلام کردهاند که اطلاعی درباره این سازمانها ندارند.

♦️مقایسه اعتماد به نهادهای دولتی و غیردولتی

نتایج نشان میدهد که مردم آمریکا به نهادهای غیردولتی (مانند دانشگاهها و سازمانهای غیرانتفاعی) اعتماد بیشتری دارند تا به دولتها. برای مثال، تنها 26 درصد از پاسخدهندگان به دولت فدرال اعتماد دارند، که نشاندهنده تردید عمومی درباره توانایی دولت در مدیریت فناوریهای پیچیده است. این در حالی است که نهادهایی که بهصورت تخصصی در حوزه هوش مصنوعی فعالیت دارند، مانند انجمن AAAI و Partnership on AI، از سطح بالاتری از اعتماد برخوردارند.

نگرانیها درباره پیامدهای بلندمدت هوش مصنوعی

♦️پیشبینی ظهور هوش مصنوعی سطح بالا

بر اساس مطالعه، 54 درصد از پاسخدهندگان معتقدند که هوش مصنوعی سطح بالا (AGI)، که قادر به انجام تقریباً تمامی وظایف انسانی است، تا سال 2028 به واقعیت خواهد پیوست. این پیشبینیها نگرانیهایی درباره تأثیرات اجتماعی و اقتصادی چنین فناوری پیشرفتهای ایجاد کرده است.

♦️نگرانی از انقراض بشر

یکی از جالبترین نتایج این نظرسنجی این است که 12 درصد از مردم باور دارند که ظهور AGI میتواند به انقراض بشر منجر شود. این نگرانیها ناشی از سناریوهایی است که در آن AI ممکن است از کنترل خارج شود و تصمیماتی بگیرد که برخلاف منافع انسانی باشد. این ترس، هرچند در میان عموم مردم رایج نیست، اما در میان کارشناسان و پژوهشگران AI به طور گستردهتری مطرح است.

♦️خطرات برای اشتغال

نگرانی درباره جایگزینی شغلها توسط اتوماسیون یکی از مسائل کلیدی در میان گروههای مختلف اجتماعی است. این نگرانی در میان افرادی که درآمد کمتر از 30,000 دلار دارند و در مشاغل یدی یا تکراری فعالیت میکنند، بسیار بیشتر است. در مقابل، کسانی که تجربه یا مهارتهایی در حوزه فناوری دارند، نگرانی کمتری در این خصوص ابراز کردهاند.

♦️پیامدهای اجتماعی و سیاسی

علاوه بر تأثیرات اقتصادی، پیامدهای اجتماعی و سیاسی AI نیز مورد توجه قرار گرفته است. استفاده از هوش مصنوعی در تصمیمگیریهای اجتماعی، از جمله در حوزههای عدالت کیفری یا سیاستگذاری عمومی، میتواند به تعمیق نابرابریها یا بروز تبعیضهای سیستماتیک منجر شود.

دیدگاه عمومی درباره هوش مصنوعی به عنوان یک خطر جهانی

♦️مقایسه با سایر خطرات

در مقایسه با خطراتی نظیر تغییرات اقلیمی یا حملات سایبری، خطرات ناشی از هوش مصنوعی از دید مردم آمریکا اهمیت کمتری دارند. تنها 12 درصد از پاسخدهندگان AI را به عنوان یک خطر جدی برای بشریت در 10 سال آینده شناسایی کردهاند.

♦️اختلاف نظر با کارشناسان

این در حالی است که بسیاری از کارشناسان بر این باورند که AI، به ویژه در صورت عدم نظارت مناسب، میتواند تهدیدی جدی برای بشریت باشد. به نظر میرسد این اختلاف نظر ناشی از فقدان آگاهی عمومی درباره چالشهای پیچیده AI باشد. اکثر مردم به دلیل عدم آشنایی با اصطلاحات تخصصی یا درک نحوه عملکرد AI، از خطرات بلندمدت آن آگاهی کافی ندارند.

♦️نیاز به آموزش عمومی

برای پر کردن شکاف میان دیدگاه عمومی و تحلیلهای کارشناسان، آموزش و آگاهیبخشی عمومی باید در اولویت قرار گیرد. کمپینهای اطلاعرسانی میتوانند به افزایش درک مردم از کاربردهای AI و پیامدهای احتمالی آن کمک کنند.

پیشنهادها برای مدیریت بهتر هوش مصنوعی با رویکرد ایران

با توجه به شرایط خاص ایران در حوزه فناوری و جامعهشناسی، پیشنهادها برای مدیریت بهتر هوش مصنوعی باید همگام با واقعیتهای فرهنگی، اقتصادی و سیاسی کشور تدوین شوند. این پیشنهادها میتوانند در قالب سیاستهای ملی و منطقهای مورد استفاده قرار گیرند:

1. ایجاد قوانین شفاف و ملی متناسب با ارزشهای بومی

تدوین مقررات ملی هوش مصنوعی: قوانین باید با توجه به ارزشهای فرهنگی و اجتماعی ایران و نیازهای اقتصادی تنظیم شوند. بهعنوانمثال، قوانین مرتبط با استفاده از دادههای شخصی و حریم خصوصی باید تضمینکننده حقوق شهروندی باشند.

ایجاد نظام حقوقی شفاف: استفاده از هوش مصنوعی در حوزههای حساس مانند قوه قضائیه، بانکداری و سلامت باید با چارچوبهای حقوقی مشخصی همراه باشد که از سوءاستفاده یا تبعیض جلوگیری کند.

2. افزایش آگاهی عمومی و ارتقای سواد دیجیتال

برنامههای آموزشی گسترده: برای ارتقای آگاهی عمومی از فرصتها و تهدیدهای هوش مصنوعی، آموزش در مدارس، دانشگاهها و رسانههای عمومی ضروری است. موضوعاتی مانند امنیت سایبری، حریم خصوصی و تأثیرات هوش مصنوعی بر اشتغال باید به زبان ساده و کاربردی آموزش داده شوند.

گسترش دسترسی به منابع آموزشی: پلتفرمهای آنلاین میتوانند با ارائه محتواهای رایگان و کاربردی درباره هوش مصنوعی، دسترسی عموم مردم به این فناوری را تسهیل کنند.

3. تمرکز بر توسعه داخلی و حمایت از استارتاپها

حمایت از شرکتهای دانشبنیان: ارائه تسهیلات مالی و قانونی به شرکتهای فعال در زمینه هوش مصنوعی میتواند نوآوری را در داخل کشور تقویت کند. ایران باید از ظرفیتهای انسانی موجود، از جمله متخصصان فناوری و مهندسان جوان، برای توسعه سیستمهای هوش مصنوعی بومی استفاده کند.

تشکیل مراکز تخصصی منطقهای: راهاندازی مراکز تحقیقاتی و پارکهای فناوری در استانهای مختلف میتواند از تمرکزگرایی جلوگیری کرده و توسعه را در مناطق کمتر توسعهیافته نیز تسریع کند.

4. تقویت همکاریهای منطقهای و بینالمللی

همکاری با کشورهای منطقه: ایران میتواند با کشورهای همسایه در حوزههایی مانند امنیت سایبری، پزشکی مبتنی بر هوش مصنوعی و مدیریت منابع آب همکاری کند. این همکاریها میتواند به ایجاد یک بلوک فناوری در منطقه منجر شود.

استفاده از ظرفیت سازمانهای بینالمللی: سازمانهایی مانند یونسکو یا اتحادیه بینالمللی مخابرات (ITU) میتوانند به ایران در توسعه استانداردهای اخلاقی و فنی کمک کنند.

5. ایجاد اعتماد عمومی از طریق شفافیت

شفافیت در فرآیندها: نهادهای دولتی و خصوصی باید اطلاعات شفاف و دقیقی درباره نحوه استفاده از دادههای شهروندان ارائه دهند. این امر میتواند از ایجاد بدبینی عمومی نسبت به فناوری جلوگیری کند.

تعامل بیشتر با مردم: از طریق برگزاری نشستها و مشاورههای عمومی، میتوان مشارکت شهروندان در سیاستگذاریهای مرتبط با هوش مصنوعی را افزایش داد.

6. تمرکز بر اخلاق در هوش مصنوعی

ایجاد چارچوبهای اخلاقی: استفاده از هوش مصنوعی در حوزههایی مانند قضاوت، پلیس و پزشکی نیازمند استانداردهای اخلاقی است که از بروز نابرابری و تبعیض جلوگیری کند.

آموزش اخلاق هوش مصنوعی: دانشجویان رشتههای مرتبط باید آموزشهایی درباره اصول اخلاقی استفاده از هوش مصنوعی دریافت کنند تا درک بهتری از مسئولیتهای خود در آینده داشته باشند.

7. استفاده از هوش مصنوعی برای حل چالشهای ملی

هوش مصنوعی میتواند ابزار موثری برای مقابله با مشکلات کلیدی کشور باشد:

مدیریت منابع آب و انرژی: استفاده از الگوریتمهای هوش مصنوعی میتواند بهرهوری در مصرف آب و انرژی را افزایش دهد و از بحرانهای آینده جلوگیری کند.

توسعه خدمات سلامت: ایجاد سامانههای پیشبینی بیماری، بهبود دسترسی به خدمات درمانی در مناطق دورافتاده و تحلیل دادههای سلامت میتواند بهبود چشمگیری در نظام بهداشت کشور ایجاد کند.

حملونقل هوشمند: استفاده از هوش مصنوعی در مدیریت ترافیک و توسعه حملونقل عمومی هوشمند میتواند مشکلات کلانشهری مانند تهران را کاهش دهد.

8. تشویق به پژوهشهای بومی و کاربردی

تمرکز بر پژوهشهای ملی: دانشگاهها و مراکز تحقیقاتی باید به پروژههای کاربردی که مستقیماً به چالشهای ایران مرتبط هستند، اولویت دهند. بهعنوانمثال، تحلیل دادههای زیستمحیطی یا بهینهسازی زنجیره تأمین در صنایع مختلف میتواند مورد توجه قرار گیرد.

حمایت از پژوهشگران ایرانی خارج از کشور: دولت باید تلاش کند تا پژوهشگران ایرانی خارج از کشور را تشویق به همکاری در پروژههای ملی کند.

جمعبندی

ایران با وجود چالشهای اقتصادی و فنی، پتانسیل بالایی در بهرهبرداری از هوش مصنوعی دارد. با تدوین قوانین ملی، افزایش آگاهی عمومی، و تقویت همکاریهای منطقهای، میتوان این فناوری را به ابزاری موثر برای حل مشکلات کلیدی کشور تبدیل کرد. از سوی دیگر، شفافیت در فرآیندها و تمرکز بر اخلاق در استفاده از هوش مصنوعی، میتواند اعتماد عمومی را جلب کند و راه را برای پیشرفتهای پایدار در این حوزه باز کند.

منابع

Zhang, Baobao & Allan Dafoe

Artificial Intelligence: American Attitudes and Trends.

Center for the Governance of AI, Future of Humanity Institute, University of Oxford, January 2019.

Morning Consult (2017)

Public Opinion on Artificial Intelligence.

مطالعهای درباره دیدگاه عمومی نسبت به هوش مصنوعی و پیامدهای آن.

Eurobarometer (2017)

Special Eurobarometer #460: Robots and Artificial Intelligence.

بررسی نگرش شهروندان اروپایی نسبت به فناوریهای جدید، از جمله هوش مصنوعی.

World Economic Forum (2018)

The Global Risks Report.

گزارشی جامع درباره مهمترین خطرات جهانی از جمله چالشهای فناوری و هوش مصنوعی.

OECD (2018)

Automation, Skills Use, and Training.

سازمان همکاری و توسعه اقتصادی، گزارشی درباره تأثیر اتوماسیون بر مهارتها و آموزشهای شغلی.

Reinhart, R. (2018)

Americans’ Perceptions of Artificial Intelligence.

مطالعهای که به بررسی آگاهی عمومی مردم آمریکا از فناوریهای مبتنی بر AI میپردازد.

Ipsos MORI (2018)

Public Awareness of Machine Learning and AI in the UK.

گزارش درباره شناخت عمومی نسبت به یادگیری ماشین و هوش مصنوعی در بریتانیا.

Pinker, Steven (2018)

Enlightenment Now: The Case for Reason, Science, Humanism, and Progress.

کتابی که به بررسی پیشرفتهای علمی و تکنولوژیکی، از جمله هوش مصنوعی، میپردازد.

Rosling, H., Rosling, O., & Rönnlund, A. R. (2018)

Factfulness: Ten Reasons We're Wrong About the World–and Why Things Are Better Than You Think.

کتابی که تصورات نادرست درباره چالشهای جهانی و نقش فناوریها را تحلیل میکند.

Global Challenges Foundation (2016)

Global Catastrophic Risks Report.

بررسی خطرات بالقوهای که میتوانند تأثیرات جهانی داشته باشند، از جمله پیشرفتهای ناامن هوش مصنوعی.