به گزارش سراج24؛ هر چیزی که تا به حال در اینترنت منتشر کرده اید تقریبا به طور قطع به عنوان بخشی از مطالب آموزشی برای بمباران کنونی هوش مصنوعی مولد مورد استفاده قرار گرفته است.

ابزارهای مدل زبانی بزرگ، مانند چت جیپیتی، با حجم عظیمی از دادههای ما کار میکنند؛ و حتی اگر یک چت بات یا یک ابزار مولد دیگر را تغذیه نکنند، دادههایی که به سرورهای متعدد اینترنت وارد کردهاید ممکن است برای ویژگیهای یادگیری ماشینی استفاده شوند.

شرکتهای فناوری اغلب بدون توجه به خالقان محتوا، قوانین کپی رایت، یا حریم خصوصی، بخشهای وسیعی از وب را به منظور تامین دادههایی که برای ایجاد هوش مصنوعی مولد مورد نیاز است جمع آوری میکنند. علاوه بر این، شرکتهایی که پستهای افراد را بازنشر میکنند، به دنبال این هستند که با فروش یا صدور مجوز اطلاعات کاربران، طلای هوش مصنوعی را به دست آورند.

با این حال، با بالا گرفتن پروندههای قضایی و تحقیقات پیرامون هوش مصنوعی مولد و شیوههای دادهای مبهم آن، حرکتهای کوچکی برای دادن کنترل بیشتر به مردم بر آنچه که در اینترنت پست میکنند، صورت گرفته است. در حال حاضر برخی شرکتها به افراد و مشتریان تجاری اجازه میدهند تا محتوای خود را در آموزش هوش مصنوعی مورد استفاده قرار دهند یا برای اهداف آموزشی به فروش برسانند.

یک محدودیت بزرگ وجود دارد

بسیاری از شرکتهای سازنده هوش مصنوعی قبلاً وب را درنوردیدهاند، بنابراین هر چیزی که شما پست کرده اید احتمالا در سیستمهای آنها وجود دارد. شرکتهای هوش مصنوعی همچنین تمایل دارند در مورد آنچه که واقعا برای آموزش سیستمهای خود خریداری کرده اند، یا از آن استفاده کرده اند، مخفی باشند. نیلوفر میرعشقالله، محققی که بر روی حریم خصوصی هوش مصنوعی در دانشگاه واشنگتن تمرکز دارد، میگوید: ما واقعا چیز زیادی نمیدانیم.

میرعشقالله توضیح میدهد که شرکتها میتوانند انتخاب استفاده از دادهها برای آموزش هوش مصنوعی را پیچیده کنند و حتی در صورت امکان، بسیاری از افراد ایده روشنی در مورد مجوزهایی که با آنها موافقت کرده اند یا نحوه استفاده از دادهها ندارند. این پیش از آن است که قوانین مختلف، مانند حمایت از کپی رایت و قوانین حریم خصوصی قوی اروپا، در نظر گرفته شوند. فیسبوک، گوگل، ایکس و دیگر شرکتها در سیاستهای حریم خصوصی خود نوشته اند که ممکن است از دادههای شما برای آموزش هوش مصنوعی استفاده کنند.

میرعشقالله میگوید اگرچه روشهای فنی مختلفی وجود دارد که سیستمهای هوش مصنوعی میتوانند دادهها را از آنها حذف کنند یا از یاد ببرند، اما اطلاعات بسیار کمی در مورد فرایندهای موجود وجود دارد. حذف پستها از دادههای آموزشی هوش مصنوعی احتمالا نبردی دشوار خواهد بود. جایی که شرکتها شروع به فراهم کردن امکان انتخاب برای اشتراک گذاری یا اشتراک گذاری دادهها در آینده میکنند، تقریباً همیشه کاربران را بهطور پیشفرض وادار میکنند که در آن شرکت کنند.

تورین کلوسکی، فعال امنیت و حریم خصوصی در بنیاد مرزهای الکترونیکی میگوید: اغلب شرکتها این گزینه را اضافه میکنند، چون میدانند که مردم به دنبال آن نخواهند رفت. انتخاب کردن در مقابل انصراف یک اقدام هدفمند خواهد بود، آن هم زمانی که بدانید چنین قابلیتی وجود دارد.

جنیفر مارتینز، یکی از سخنگویان آنتروپیک میگوید: برخی از شرکتهای سازنده ابزارهای هوش مصنوعی و مدلهای یادگیری ماشین به صورت خودکار مشتریان را انتخاب نمیکنند. ما مدلهای خود را به صورت پیش فرض روی دادههای ارائه شده توسط کاربر آموزش نمیدهیم. ما میتوانیم از محرکها و خروجیهای کاربر برای آموزش کلود استفاده کنیم؛ جایی که کاربر به ما اجازه میدهد تا این کار را انجام دهیم. در این وضعیت، جدیدترین نسخه چت بات کلود این شرکت براساس اطلاعات عمومی آنلاین و دادههای شخص ثالث، محتوایی که افراد در جاهای دیگر آنلاین پست میکنند ساخته شده است.

چت جی پی تی

مردم هنگام استفاده از یک چت بات، انواع و اقسام اطلاعات شخصی خود را فاش میکنند. اپن ایآی گزینههایی را برای آنچه شما به چت جیپیتی میگویید فراهم میکند، از جمله اینکه به مدلهای هوش مصنوعی آینده خود اجازه میدهد روی محتوا آموزش نبینند. تایا کریستینسون، یکی از سخنگویان اپن ایآی میگوید: گزینهها بسته به نوع حساب شما کمی متفاوت هستند و از دادههای مشتریان سازمانی برای آموزش مدلها استفاده نمیشود.

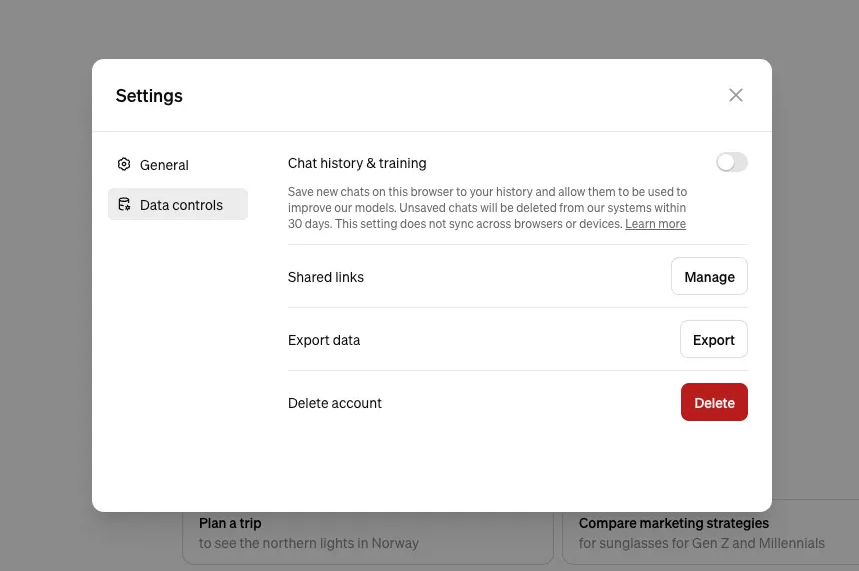

اپن ایآی در صفحات راهنمای خود میگوید کاربران وب چت جیپیتی که میخواهند انصراف دهند باید به تنظیمات، کنترل دادهها بروید و سپس تیک گزینه Improve the model for all را بردارند. اپن ایآی بسیار گستردهتر از چت جیپیتی است. این استارتاپ برای هوش مصنوعی مولد تصویر دال-ای ۳ خود فرمی دارد که به شما اجازه میدهد تصاویری که ارسال میکنید از مجموعه دادههای آموزشی آینده حذف شوند.

گوگل جمنای

گاهی اوقات در جمنای، چت بات گوگل ممکن است مکالمات برای بررسی انسانی انتخاب شوند تا مدل هوش مصنوعی بهبود یابد. با این حال تشخیص آن ساده است. جمنای را در مرورگر خود باز کنید، روی گزینه Activity کلیک کنید و منوی کشویی Turn Off را انتخاب کنید. در اینجا فقط می توانید فعالیت اپلیکیشن های جمنای را خاموش کنید، یا می توانید داده های مکالمه خود را حذف کنید. در حالی که این بدان معنی است که در اغلب موارد چت های آینده برای بررسی انسانی دیده نخواهند شد، داده هایی که از قبل انتخاب شده از طریق این فرآیند پاک نمی شوند. به گفته مرکز حریم خصوصی گوگل برای جمنای، این چت ها ممکن است به مدت سه سال باقی بمانند.

گرامرلی

هوش مصنوعی گرامرلی نیز سیاست های خود را به روز کرده است، بنابراین حساب های شخصی اکنون می توانند از آموزش هوش مصنوعی استفاده کنند. این کار را با رفتن به Account و سپس Settings و خاموش کردن بخش بهبود و آموزش محصول انجام دهید.